- Published on

🧠 Khám phá AI #6: Giải thích về Học không giám sát

- Authors

- Name

- Nguyễn Văn Lộc

- @vanloc1808

🧠 Khám phá AI #6: Giải thích về Học không giám sát

Không giống như học có giám sát, học không giám sát không dựa vào dữ liệu có nhãn. Thay vào đó, nó khám phá các mẫu và cấu trúc ẩn trong dữ liệu đầu vào — làm cho nó trở nên lý tưởng cho khám phá, nén, và hiểu các tập dữ liệu chưa biết.

Trong bài viết này, chúng ta sẽ khám phá các khái niệm cốt lõi của học không giám sát, các kỹ thuật chính, ứng dụng thực tế, và một ví dụ Python minh họa.

🧭 Học không giám sát là gì?

Trong học không giám sát, mô hình được cung cấp dữ liệu đầu vào mà không có nhãn nào và phải khám phá:

- Các cụm hoặc nhóm của các mẫu tương tự

- Cấu trúc hoặc mẫu cơ bản

- Biểu diễn chiều thấp hơn của dữ liệu

Bạn không nói với mô hình phải dự đoán gì — bạn để nó tự tìm cấu trúc.

🔍 Ví dụ thực tế: Phân khúc khách hàng

Hãy tưởng tượng bạn đang phân tích hành vi khách hàng trên một trang thương mại điện tử:

- Đầu vào: Lịch sử mua hàng, lượt xem trang, nhân khẩu học

- Không có nhãn.

- Mục tiêu: Nhóm khách hàng thành các cụm như "người săn hàng giảm giá", "người mua trung thành", hoặc "người chỉ xem"

Học không giám sát giúp phân khúc người dùng cho marketing có mục tiêu, mà không cần kiến thức trước về danh mục của họ.

🧠 Các kỹ thuật học không giám sát phổ biến

| Kỹ thuật | Mô tả | Trường hợp sử dụng ví dụ |

|---|---|---|

| Phân cụm | Nhóm dữ liệu thành các cụm riêng biệt | Phân khúc khách hàng, phát hiện bất thường |

| Giảm chiều | Nén đặc trưng trong khi bảo toàn cấu trúc | Trực quan hóa dữ liệu, giảm nhiễu |

| Quy tắc liên kết | Tìm mẫu trong giao dịch | Phân tích giỏ hàng (ví dụ: "người dùng mua X cũng mua Y") |

🧪 Các thuật toán phổ biến

| Thuật toán | Loại | Mô tả |

|---|---|---|

| K-Means | Phân cụm | Gán điểm cho K cụm dựa trên độ tương tự |

| DBSCAN | Phân cụm | Nhóm dữ liệu theo mật độ; tốt cho hình dạng không đều |

| Phân cụm phân cấp | Phân cụm | Xây dựng cây các cụm lồng nhau |

| PCA | Giảm chiều | Chiếu dữ liệu lên các trục chính để trực quan hóa |

| t-SNE / UMAP | Giảm chiều | Bảo toàn cấu trúc cục bộ để trực quan hóa |

| Apriori / FP-Growth | Quy tắc liên kết | Khai thác tập mục thường xuyên và quy tắc trong giao dịch |

📊 Đánh giá (mà không có nhãn?)

Ngay cả khi không có nhãn, chúng ta vẫn có thể đánh giá các mô hình không giám sát:

| Thước đo | Trường hợp sử dụng |

|---|---|

| Điểm Silhouette | Độ compact và phân tách của cụm |

| Inertia (K-Means) | Tổng bình phương trong cụm |

| Lỗi tái tạo | Cho giảm chiều và autoencoder |

🧪 Ví dụ mã: Phân cụm dữ liệu Iris với K-Means

from sklearn.datasets import load_iris

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

import seaborn as sns

import pandas as pd

# 📥 Tải dữ liệu Iris

iris = load_iris()

X = iris.data

labels = iris.target

features = iris.feature_names

# 🔍 Áp dụng phân cụm KMeans

kmeans = KMeans(n_clusters=3, random_state=42)

clusters = kmeans.fit_predict(X)

# 📊 Trực quan hóa các cụm

df = pd.DataFrame(X, columns=features)

df['Cluster'] = clusters

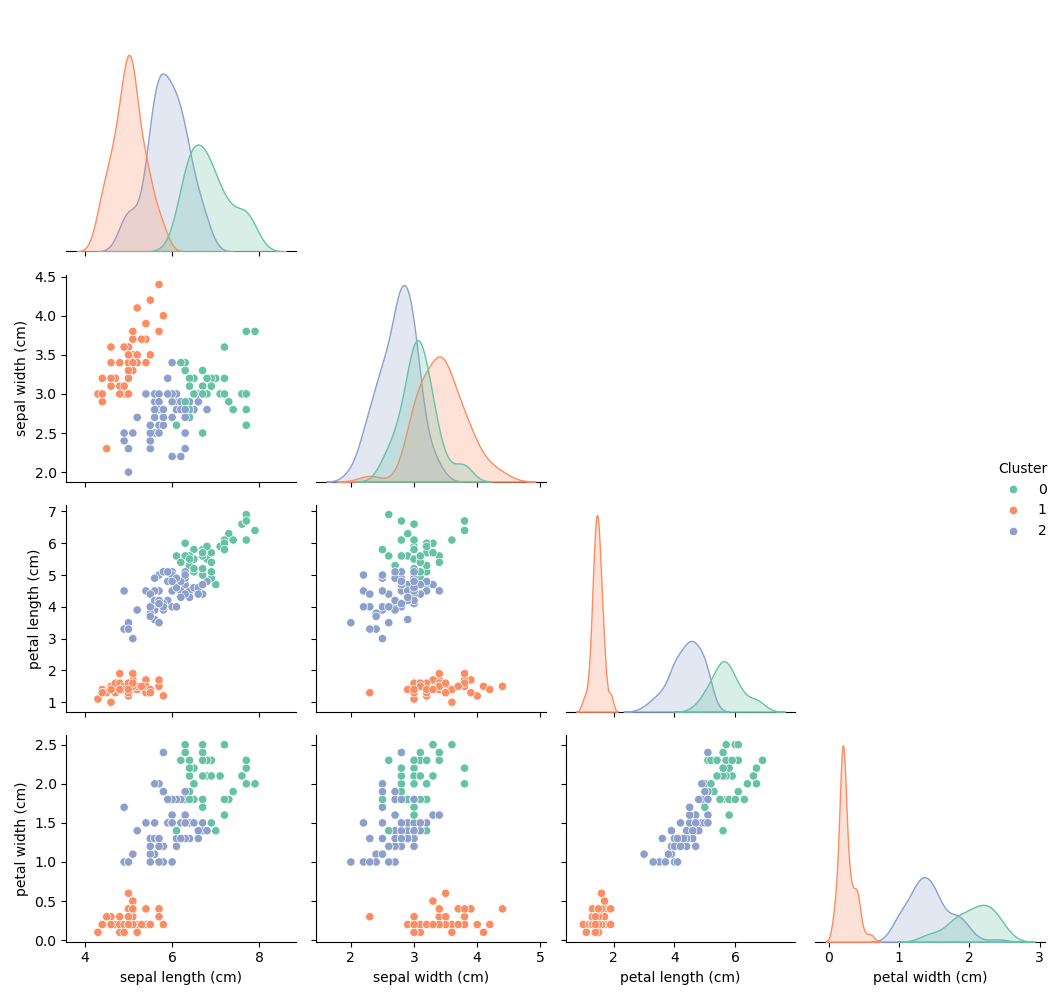

sns.pairplot(df, hue='Cluster', palette='Set2', corner=True)

plt.suptitle('Phân cụm K-Means trên tập dữ liệu Iris', y=1.02)

plt.tight_layout()

plt.show()

Ví dụ này phân cụm tập dữ liệu Iris thành 3 nhóm mà không sử dụng nhãn loài thực — cho thấy sức mạnh của học không giám sát trong việc khám phá cấu trúc.

📊 Biểu đồ pair plot dưới đây cho thấy K-Means đã phân cụm tập dữ liệu Iris thành ba nhóm riêng biệt dựa trên độ tương tự đặc trưng — mà không sử dụng nhãn loài thực. Đáng chú ý, các cụm căn chỉnh tốt với loài thực tế, đặc biệt khi chiều dài cánh hoa và chiều rộng cánh hoa được liên quan, cho thấy sức mạnh của học không giám sát trong việc khám phá cấu trúc tự nhiên.

📈 Dọc theo đường chéo, mỗi subplot là một biểu đồ KDE (Kernel Density Estimate), visualizes cách các giá trị của một đặc trưng cụ thể được phân phối trong mỗi cụm:

- Mỗi đường cong màu đại diện cho một cụm (ví dụ: Cụm 0, 1, hoặc 2).

- Trục x là giá trị đặc trưng (ví dụ: chiều rộng cánh hoa), trong khi trục y là mật độ ước tính.

- Các đỉnh trong biểu đồ KDE cho thấy nơi các điểm dữ liệu tập trung — giúp bạn thấy đặc trưng nào tách biệt các cụm tốt nhất.

- Nếu các đường cong KDE được tách biệt rõ ràng, đặc trưng đó đóng góp mạnh mẽ vào việc phân cụm.

✅ Khi nào sử dụng Học không giám sát

- Khi bạn có dữ liệu không có nhãn

- Khi bạn muốn khám phá hoặc trực quan hóa tập dữ liệu của mình

- Khi bạn đang xây dựng hệ thống gợi ý, bộ phát hiện bất thường, hoặc công cụ phân khúc thị trường

🔚 Tóm tắt

Học không giám sát mở khóa sức mạnh của khám phá mẫu trong dữ liệu thô, không có nhãn. Từ phân cụm đến giảm chiều, nó tạo thành xương sống của nhiều quy trình khoa học dữ liệu khám phá.

🔜 Tiếp theo

Trong bài viết tiếp theo, chúng ta sẽ khám phá Học bán giám sát — nơi một lượng nhỏ dữ liệu có nhãn hướng dẫn việc học trên một nhóm lớn dữ liệu không có nhãn.

Hãy tò mò và tiếp tục khám phá 👇

🙏 Lời cảm ơn

Cảm ơn ChatGPT đã cải thiện bài viết này với các gợi ý, định dạng và biểu tượng cảm xúc.